¿QUÉ ES EL SEO ON-SITE?

Una de las formas más populares de categorizar el trabajo SEO es en on-site y off-site.

El SEO on-site es el análisis y la optimización de una página web enfocado desde la perspectiva tanto del usuario, como de los motores de búsqueda.

Entre las acciones que podemos hacer para optimizar el rendimiento de nuestra web están:

Mejora de contenidos: Proporcionar un valor único, trabajar formatos diferentes (vídeo, infografías, audio), añadir nuevas funcionalidades, comprobación de etiquetas title y H1, etc.

Revisión de textos e imágenes: Cuidar el estilo y la ortografía, adaptar contenido a nuestro perfil de usuario, asegurarnos de que las palabras clave aparecen en los textos.

Formato de URLs: Cuidar el formato de las URLS evitando caracteres innecesarios, eliminar stop words (artículos, determinantes, preposiciones y términos que no aparezcan en la búsqueda), etc.

Código y metadatos: Cuidar la metadescription, minimizar llamadas

Optimización del tiempo de carga: Reducir llamadas http mediante reducción de JS y CSS y creando sprites, optimización de imágenes, reducción de código, revisar caché y compresión del servidor Etc..

Con cambios como Google Panda y Google Penguin, el trabajo SEO ha pasado a volcarse en la optimización on-site y la creación de contenido de calidad como medio de mejorar una web, la experiencia del usuario y conseguir links.

Espesemos

En este turorial tocare 4 puntos en los cuales volcare toda vuestra atención:

1. Movil

2. SEO

3. Usabilidad

4. Tecnologías

Por el gran Contenido Textual, grafico y de referencia agregare diariamente los diversos factores hasta terminar este tutorial que les enseñara a muchos hacer una buena optimizan ON-SITE espero les guste mi aporte

1. Movil

Tiempo de Carga:

Intente cargar su sitio web en un dispositivo móvil y mida el tiempo que tarda en cargarse. Si le lleva más de cinco segundos descargarse en un dispositivo móvil, ¡podría perder el 74% de sus visitantes! Ver infografía

El uso de los móviles está creciendo muy rápido, en especial en Norteamérica, donde pronto se situará por delante de la navegación web desde el ordenador.

Asegúrese de que su sitio web se carga rápido y de que su apariencia es atractiva en todo tipo de dispositivos móviles.

No utilice Flash y reduzca al mínimo las fotos y los vídeos. Estos son dos consejos útiles de Google™ para optimizar la velocidad de la versión móvil de su sitio web.

9 consejos para optimizar la velocidad del sitio móvil

Optimización móvil

Asegúrese de que su web está preparada para la navegación móvil. Estos son los distintos aspectos que pueden optimizarse para los usuarios de móviles:

CSS para móviles

Meta Viewport Tag

Icono Apple

Redirección a versión móvil

Sin contenido Flash

2. SEO

Resolver www

Asegúrese de que www.miweb.com y miweb.com no están funcionando en paralelo.

Las solicitudes de re-direccionamiento de nombres de dominio secundarios son importantes porque los motores de búsqueda interpretan las URL con y sin www como dos sitios web diferentes.

Una vez establecido su dominio primario, utilice una redirección 301 para todo aquel tráfico que llegue al dominio secundario.

Como hacerlo

El re-direccionamiento puede hacerse mediante el archivo .htaccess

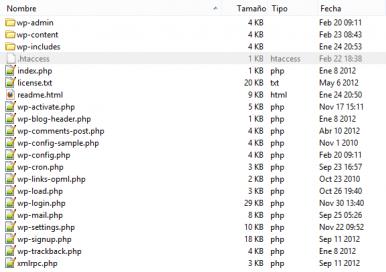

Se trata de un archivo oculto situado en la carpeta raíz de tu Web, por lo que tendrás que activar la opción de “ver archivos ocultos” en las preferencias de tu cliente FTP.

Si utilizas el código siguiente en el archivo .htaccess se creará una redirección 301 permanente del dominio sin WWW al dominio con WWW:

Por el contrario, si utilizas el siguiente código la redirección será del dominio con WWW al dominio sin WWW (sustituye “tudominio” y “.com” por el nombre de dominio y el TLD de tu Web):

Reescribir URL o URL Amigable

Las URL semánticas o URL amigables son aquellas URLs que son, dentro de lo que cabe, entendibles para el usuario. Lejos de las clásicas URLs de las páginas dinámicas llenas de variables GET y números difíciles de recordar, las URL semánticas están formadas con palabras relacionadas con el contenido de la página y fáciles de recordar. Estas se utilizan en los sitios web dinámicos (no estáticos). Por ello se están utilizando mucho más que las URL extensas.

URL no semántica

Las urls en las páginas dinámicas suelen tener este formato. Imaginemos que entramos en una página web a leer una noticia que habla sobre como crear URL amigables:

Si tenemos conocimiento de programación web sabremos que estamos accediendo al archivo index.php en www.miweb.com, pesándola a este las variables sección e id_noticia con los valores "noticias" y 133 respectivamente. Si dentro de un tiempo queremos volver a esa página difícilmente recordaremos dicha url. Y a su vez si vemos esta URL sin entrar a la página nos será imposible saber de que trata.

URL semántica

Con la intención de hacer estas URLs más fáciles de entender y a su vez de recordar surgen las URL amigables. La URL anterior podría quedar de esta forma si la semantizamos:

De esta forma con sólo leer la url sabremos de lo que trata la página y se nos hará mucho más fácil de recordar en un futuro.

Problema con los buscadores

Cada día son más los sitios web que optan por mostrar este tipo de URLs con el fin de que sean indexadas, ya que los buscadores indexan las URL no semánticas sin agregar peso a las palabras adecuadas, devaluando el contenido de la página en los resultados orgánicos. De ahí que surja el nombre de "amigable", pues serán unas URL amigables para los buscadores. Dicho problema que dan las URL tradicionales ha sido el gran impulsor de semantizar muchas de las urls que encontramos en internet.

En este enlace puedes ver como crear URLs Amigables

Robots.txt

Un fichero robots.txt permite restringir el acceso a los robots de los motores de búsqueda que rastrean la web y puede evitar que accedan a directorios y páginas determinadas. También especifica la ubicación del archivo del mapa del sitio XML o Sitemap.xml.

Como hacerlo

Lo primero que tenemos que hacer es abrir un documento de texto desde el ordenador y nombrarlo “robots” y que tenga la extensión “.txt”; una vez que insertemos el código adecuado (dependiendo las necesidades del sitio), lo subimos a la raíz de la página web vía FTP.

Ahora si queremos bloquear una carpeta del sitio web, para que el robot de los buscadores no tengan acceso a la misma, le insertaremos este código al archivo “robots.txt”:

En cambio si lo que buscamos es que el sitio web esté totalmente bloqueado y el robot no pueda ingresar a ninguna carpeta, contenido o archivo copiamos el siguiente código:

Y si lo que buscamos es tener una página web que no sea indexada por los buscadores web, insertamos el siguiente código:

Pero si lo que buscamos es restringirle a los buscadores algún acceso, pero que tengan acceso a los artículos, imágenes, el contacto y otras carpetas, insertamos el siguiente código:

Y si lo que tenemos es un CMS (Joomla, WordPress, Drupal, etc.), tenemos que copiar este código:

Con estos ejemplos podrás crear o personalizar el archivo robots.txt de una página web. Este archivo es importante tenerlo bien configurado si queremos que la página web tenga un buen posicionamiento web y llegar a los primeros puestos de los principales buscadores web. Para ampliar la información se pueden dirigir al sitio web oficial de “robottxt”.

Sitio Oficial:robotstxt

Mapa del Sitio o Sitemap

Un mapa del sitio enumera las URL que pueden rastrearse y puede incluir información adicional, como las últimas actualizaciones de su sitio web, la frecuencia de cambios y la importancia de las URL. Esto permite a los motores de búsqueda rastrear el sitio web de una forma más exhaustiva.

Cómo Crear un Sitemap XML y Enviarlo al Buscador Fácil y Rápidamente

Una de las formas más populares de categorizar el trabajo SEO es en on-site y off-site.

El SEO on-site es el análisis y la optimización de una página web enfocado desde la perspectiva tanto del usuario, como de los motores de búsqueda.

Entre las acciones que podemos hacer para optimizar el rendimiento de nuestra web están:

Mejora de contenidos: Proporcionar un valor único, trabajar formatos diferentes (vídeo, infografías, audio), añadir nuevas funcionalidades, comprobación de etiquetas title y H1, etc.

Revisión de textos e imágenes: Cuidar el estilo y la ortografía, adaptar contenido a nuestro perfil de usuario, asegurarnos de que las palabras clave aparecen en los textos.

Formato de URLs: Cuidar el formato de las URLS evitando caracteres innecesarios, eliminar stop words (artículos, determinantes, preposiciones y términos que no aparezcan en la búsqueda), etc.

Código y metadatos: Cuidar la metadescription, minimizar llamadas

Optimización del tiempo de carga: Reducir llamadas http mediante reducción de JS y CSS y creando sprites, optimización de imágenes, reducción de código, revisar caché y compresión del servidor Etc..

Con cambios como Google Panda y Google Penguin, el trabajo SEO ha pasado a volcarse en la optimización on-site y la creación de contenido de calidad como medio de mejorar una web, la experiencia del usuario y conseguir links.

Espesemos

En este turorial tocare 4 puntos en los cuales volcare toda vuestra atención:

1. Movil

2. SEO

3. Usabilidad

4. Tecnologías

Por el gran Contenido Textual, grafico y de referencia agregare diariamente los diversos factores hasta terminar este tutorial que les enseñara a muchos hacer una buena optimizan ON-SITE espero les guste mi aporte

1. Movil

Tiempo de Carga:

Intente cargar su sitio web en un dispositivo móvil y mida el tiempo que tarda en cargarse. Si le lleva más de cinco segundos descargarse en un dispositivo móvil, ¡podría perder el 74% de sus visitantes! Ver infografía

El uso de los móviles está creciendo muy rápido, en especial en Norteamérica, donde pronto se situará por delante de la navegación web desde el ordenador.

Asegúrese de que su sitio web se carga rápido y de que su apariencia es atractiva en todo tipo de dispositivos móviles.

No utilice Flash y reduzca al mínimo las fotos y los vídeos. Estos son dos consejos útiles de Google™ para optimizar la velocidad de la versión móvil de su sitio web.

9 consejos para optimizar la velocidad del sitio móvil

Optimización móvil

Asegúrese de que su web está preparada para la navegación móvil. Estos son los distintos aspectos que pueden optimizarse para los usuarios de móviles:

CSS para móviles

Meta Viewport Tag

Icono Apple

Redirección a versión móvil

Sin contenido Flash

2. SEO

Resolver www

Asegúrese de que www.miweb.com y miweb.com no están funcionando en paralelo.

Las solicitudes de re-direccionamiento de nombres de dominio secundarios son importantes porque los motores de búsqueda interpretan las URL con y sin www como dos sitios web diferentes.

Una vez establecido su dominio primario, utilice una redirección 301 para todo aquel tráfico que llegue al dominio secundario.

Como hacerlo

El re-direccionamiento puede hacerse mediante el archivo .htaccess

Se trata de un archivo oculto situado en la carpeta raíz de tu Web, por lo que tendrás que activar la opción de “ver archivos ocultos” en las preferencias de tu cliente FTP.

Si utilizas el código siguiente en el archivo .htaccess se creará una redirección 301 permanente del dominio sin WWW al dominio con WWW:

HTML:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^www\.

RewriteRule ^(.*)$ http://www.%{HTTP_HOST}/$1 [R=301,L]Por el contrario, si utilizas el siguiente código la redirección será del dominio con WWW al dominio sin WWW (sustituye “tudominio” y “.com” por el nombre de dominio y el TLD de tu Web):

HTML:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^tudominio\.com$ [NC]

RewriteRule ^(.*)$ http://tudominio.com/$1 [R=301,L]Reescribir URL o URL Amigable

Las URL semánticas o URL amigables son aquellas URLs que son, dentro de lo que cabe, entendibles para el usuario. Lejos de las clásicas URLs de las páginas dinámicas llenas de variables GET y números difíciles de recordar, las URL semánticas están formadas con palabras relacionadas con el contenido de la página y fáciles de recordar. Estas se utilizan en los sitios web dinámicos (no estáticos). Por ello se están utilizando mucho más que las URL extensas.

URL no semántica

Las urls en las páginas dinámicas suelen tener este formato. Imaginemos que entramos en una página web a leer una noticia que habla sobre como crear URL amigables:

HTML:

http://www.miweb.com/index.php?seccion=noticias&id_noticia=133Si tenemos conocimiento de programación web sabremos que estamos accediendo al archivo index.php en www.miweb.com, pesándola a este las variables sección e id_noticia con los valores "noticias" y 133 respectivamente. Si dentro de un tiempo queremos volver a esa página difícilmente recordaremos dicha url. Y a su vez si vemos esta URL sin entrar a la página nos será imposible saber de que trata.

URL semántica

Con la intención de hacer estas URLs más fáciles de entender y a su vez de recordar surgen las URL amigables. La URL anterior podría quedar de esta forma si la semantizamos:

HTML:

http://www.miweb.com/noticias/url-amigables.htmlDe esta forma con sólo leer la url sabremos de lo que trata la página y se nos hará mucho más fácil de recordar en un futuro.

Problema con los buscadores

Cada día son más los sitios web que optan por mostrar este tipo de URLs con el fin de que sean indexadas, ya que los buscadores indexan las URL no semánticas sin agregar peso a las palabras adecuadas, devaluando el contenido de la página en los resultados orgánicos. De ahí que surja el nombre de "amigable", pues serán unas URL amigables para los buscadores. Dicho problema que dan las URL tradicionales ha sido el gran impulsor de semantizar muchas de las urls que encontramos en internet.

En este enlace puedes ver como crear URLs Amigables

Robots.txt

Un fichero robots.txt permite restringir el acceso a los robots de los motores de búsqueda que rastrean la web y puede evitar que accedan a directorios y páginas determinadas. También especifica la ubicación del archivo del mapa del sitio XML o Sitemap.xml.

Como hacerlo

Lo primero que tenemos que hacer es abrir un documento de texto desde el ordenador y nombrarlo “robots” y que tenga la extensión “.txt”; una vez que insertemos el código adecuado (dependiendo las necesidades del sitio), lo subimos a la raíz de la página web vía FTP.

Ahora si queremos bloquear una carpeta del sitio web, para que el robot de los buscadores no tengan acceso a la misma, le insertaremos este código al archivo “robots.txt”:

User-agent: *

Disallow: / confidencial.html

Disallow: / nombredelacerpeta /

En cambio si lo que buscamos es que el sitio web esté totalmente bloqueado y el robot no pueda ingresar a ninguna carpeta, contenido o archivo copiamos el siguiente código:

User-agent: *

Disallow: /

Y si lo que buscamos es tener una página web que no sea indexada por los buscadores web, insertamos el siguiente código:

User-agent: *

Disallow: / asunto-confidencial.html

Pero si lo que buscamos es restringirle a los buscadores algún acceso, pero que tengan acceso a los artículos, imágenes, el contacto y otras carpetas, insertamos el siguiente código:

User-agent: *

Allow: / articulo-web.html

Allow: / carpeta / contato.html

Allow: / imagenes /

Disallow: /

Y si lo que tenemos es un CMS (Joomla, WordPress, Drupal, etc.), tenemos que copiar este código:

Código:

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /images/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/Con estos ejemplos podrás crear o personalizar el archivo robots.txt de una página web. Este archivo es importante tenerlo bien configurado si queremos que la página web tenga un buen posicionamiento web y llegar a los primeros puestos de los principales buscadores web. Para ampliar la información se pueden dirigir al sitio web oficial de “robottxt”.

Sitio Oficial:robotstxt

Mapa del Sitio o Sitemap

Un mapa del sitio enumera las URL que pueden rastrearse y puede incluir información adicional, como las últimas actualizaciones de su sitio web, la frecuencia de cambios y la importancia de las URL. Esto permite a los motores de búsqueda rastrear el sitio web de una forma más exhaustiva.

Cómo Crear un Sitemap XML y Enviarlo al Buscador Fácil y Rápidamente